Jakob Sverre Løvstad

CTO, Seema

30. juli 2025

Noe man relativt ofte kan se i mangfoldsfaget, er at det hives ut forskjellige påstander med veldig varierende grad av troverdighet. I den minst relevante enden har man enkelthistorier med ofte mange følelser og lite generaliserbarhet. I den mer interessante enden har man studier hvor slutningsstatistikken henger noenlunde på grep slik at man i det minste vet at «her har man sannsynligvis et funn».

Men det man kanskje ikke så ofte fremhever like godt, er hvor sårbare selve verktøyene man anvender kan gjøre forskningen. Spesielt i samfunnsvitenskapelig forskning hvor veldig mye man ser på er basert på spørsmålsbatterier, er det mye som kan gå galt. Jeg husker en foreleser jeg hadde på psykologistudiet fremhevet dette veldig godt ved å forklare at psykologien som forskningsfelt ofte fikk mye tyn (spesielt fra realfaglige) for å «gjemme en sten under en busk og så bli veldig fornøyde når de så fant igjen stenen». Metaforen beskriver at man i forskning i «mykere fag» vil, til tross for avanserte statistiske metoder, gjerne får bekreftende svar på det man spør om og det funnet man er på jakt etter. Eller sagt på en folkelig måte: «Som man spør, får man svar».

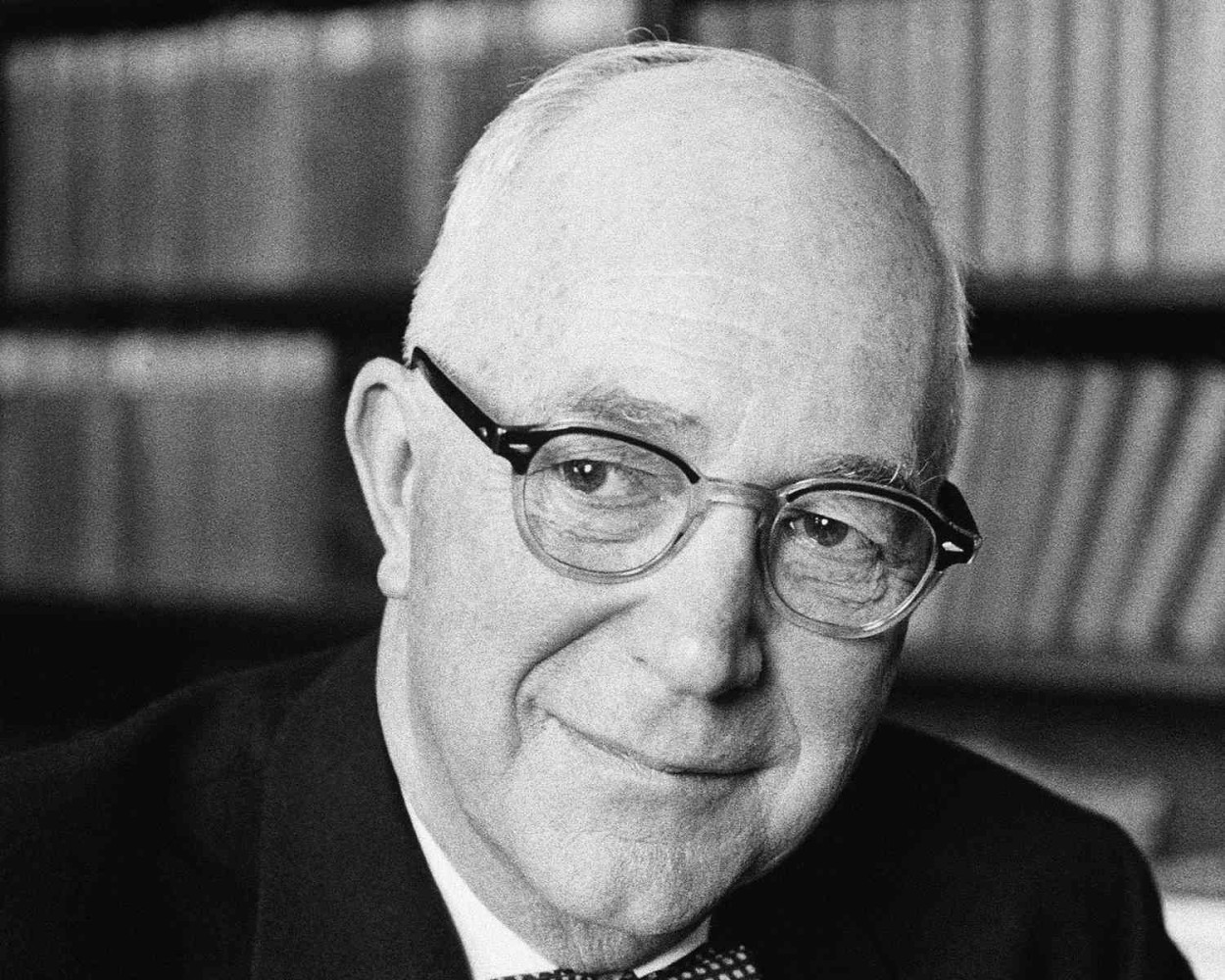

For å ta et konkret eksempel, kan vi gå tilbake til midten av forrige århundre og se til skriveriene til Gordon Allport, den kanskje aller viktigste sosialpsykologen hva gjelder å ha definert feltet rundt fordommer og diskriminering.

Som Allport påpeker, ble det i USA gjort en undersøkelse hvor spørsmålet stilt var «Do you think the Jews have too much power and influence in the United States?» (husk at vi her er 80 år tilbake i tid omtrent). I denne påstanden var 50% av respondentene enige. Vil dette da si at halvparten av befolkningen er antisemittiske?

Vel, så enkelt er det ikke. Husk at spørsmålet er ledende og får folk til å tenke på en spesifikk gruppe i en spesifikk kontekst med et hint i selve setningen om hva som er «rett» svar. I en annen undersøkelse spurte man da heller «In your opinion, what religious, national, or racial groups are a menace to America?».

På dette spørsmålet var det til sammenligning kun 10% som spontant nevnte de av jødisk herkomst som et aktuelt svar. Er da 10% antisemittisme rett andel? Nok en gang er det et «tja» her. I en tredje studie ga man respondenten en liste med gruppene «protestanter», «katolikker», «jødiske» og «afroamerikanere» listet opp og spurte to spørsmål:

- «Do you think any of these groups are getting more economic power anywhere in the United States than is good for the country?»

- «Do you think any of these groups are getting more political power anywhere in the United States than is good for the country?»

På det første spørsmålet valgte 35% de av jødisk herkomst, og 20% gjorde det samme på det andre. Kort sagt kan man ta nær sagt trille en terning på om antisemittisme lå på 10%, 20%, 35% eller 50% i utvalgene man spurte – eller kanskje lene seg på den semantikken man selv likte best.

Selv om man i moderne samfunnsvitenskapelig metode lener seg på en rekke statistiske verktøy for å sikre pålitelighet og validitet i skjemaer (og det samme i tester som ikke bygger på selvrapportering), kommer man ikke unna at utformingen av verktøyet fra forskerens side vil i stor grad definere hva utfallene kan bli. Og i så måte bør også alle brukere av forskningsfunn være gode på å lese vitenskapelige artikler ordentlig og se logikken anvendt i lys av annen forskning, gjerne også på tvers av fagfelt (som når sosiologi, psykologi og historie gir mening i sammenheng) og fasetter av eget fagfelt (som når selvrapportering sammenfaller med analyser av hjerneaktivitet og/eller atferdsstudier innen psykologi).

Og eksempelet brukt over viser forhåpentligvis på enkel måte også hvordan spesielt mangfoldsfaget kan være meget sårbart for feil her.